1. Fast API

FastAPI는 Python 기반의 웹 프레임워크로, 주로 API를 빠르게 개발하기 위해 설계되었습니다. FastAPI는 강력한 타입 힌팅(Type Hints)을 활용하여 개발자에게 코드 작성의 안정성과 가독성을 제공합니다.

https://fastapi.tiangolo.com/ko/

※ 타입 힌팅(Type Hints)

타입 힌팅(Type Hints)은 프로그래밍 언어에서 변수, 함수 매개변수, 함수 반환값 등에 대한 데이터 타입 정보를 코드에 명시적으로 제공하는 기술입니다. Python 3.5 이상에서 도입된 기능으로, 코드의 가독성을 높이고 프로그램의 안정성을 강화하는 데 도움이 됩니다.

2. Fast API vs Flask vs Django

FastApi

장점

FastAPI는 최신 Python 기반 프레임워크로 빠른 성능과 사용하기 쉬운 API로 유명합니다. 비동기 프로그래밍을 지원하므로 실시간 애플리케이션 구축에 적합합니다. 또한 자동 API 문서화 및 유효성 검사를 제공하여 개발자의 시간과 노력을 절약합니다.

단점

FastAPI는 비교적 새로운 프레임워크이며 기존 프레임워크에 비해 커뮤니티 지원 및 리소스가 많지 않을 수 있습니다. 또한 비동기 프로그래밍을 처음 접하는 개발자를 위한 학습 곡선도 있습니다.

활용도

FastAPI는 특히 데이터 집약적인 애플리케이션을 위한 실시간 및 고성능 API 구축에 적합합니다.

Django

장점

Django는 웹 애플리케이션 개발에 널리 사용되는 성숙한 Python 기반 프레임워크입니다. 인증, 관리자 패널 및 ORM과 같은 많은 기본 기능을 제공합니다. 또한 지원 및 리소스를 제공하는 크고 활동적인 커뮤니티가 있습니다.

단점

Django는 복잡할 수 있으며 설정하려면 상당한 구성이 필요합니다. 소규모 프로젝트나 경량 API

축에는 적합하지 않을 수도 있습니다.

활용

Django는 웹 애플리케이션, 특히 콘텐츠 기반 웹사이트, 전자상거래 플랫폼 및 소셜 미디어 플랫폼을 구축하는 데 널리 사용됩니다.

Flask

장점

Flask는 배우고 사용하기 쉬운 경량 Python 기반 프레임워크입니다. 유연성을 제공하고 개발자가 모듈식 및 확장 가능한 방식으로 웹 애플리케이션을 구축할 수 있도록 합니다. 또한 사용자 정의가 가능하고 소규모 프로젝트를 구축하는 데 적합합니다.

단점

Flask는 다른 프레임워크에 비해 기본 제공 기능이 적기 때문에 개발자가 구현하는 데 더 많은 노력과 시간이 필요할 수 있습니다. 또한 대규모 웹 애플리케이션을 구축하는 데 적합하지 않을 수도 있습니다.

활용

Flask는 개인 웹 사이트, 간단한 API 및 내부 대시보드와 같은 소규모 웹 애플리케이션 및 프로토타입을 구축하는 데 적합합니다.

요약

FastAPI는 실시간 및 고성능 API를 구축하는 데 적합한 현대적이고 빠른 프레임워크이고, Django는 복잡한 웹 애플리케이션을 구축하는 데 적합한 성숙한 프레임워크이며, Flask는 소규모 웹 애플리케이션 및 프로토타입을 구축하는 데 적합한 가볍고 유연한 프레임워크입니다. . 그들 사이의 선택은 개발 팀의 기술과 경험뿐만 아니라 프로젝트의 특정 요구 사항과 요구 사항에 따라 다릅니다.

3. 설치

FastAPI를 설치하기 전에 Python 가상환경을 만들어줍니다. 가상환경을 사용하면 프로젝트 간에 의존성 충돌을 방지하고 프로젝트 별로 필요한 패키지를 독립적으로 관리할 수 있습니다.

# Windows

python -m venv venv

# macOS/Linux

python3 -m venv venv

가상환경이 생성되면 해당 가상환경을 활성화합니다.

# Windows

venv\Scripts\activate

# macOS/Linux

source venv/bin/activate

FastAPI를 사용하려면 먼저 FastAPI 패키지를 설치해야 합니다.

pip install fastapi

FastAPI 애플리케이션을 실행하기 위해 uvicorn이라는 ASGI 서버가 필요합니다.

pip install "uvicorn[standard]"

uvicorn[standard]

1. 이 패키지는 uvicorn에 기본적으로 포함된 기능 외에도 추가적인 표준 미들웨어를 포함합니다.

2. 표준 미들웨어는 보안, 로깅 및 기타 서버 관련 기능을 추가하는 데 도움이 됩니다.

3. 예를 들어, Gzip 압축, CORS(Cross-Origin Resource Sharing) 지원 등이 기본적으로 포함되어 있습니다.

uvicorn

1. 기본적으로 필요한 최소한의 기능만을 제공하는 패키지입니다.

2. uvicorn[standard]에 비해 미들웨어가 적고, 기본적인 서버 기능만을 제공합니다.

※ ASGI 서버

ASGI는 Asynchronous Server Gateway Interface의 약자로, 비동기 웹 애플리케이션과 서버 간의 표준 인터페이스를 제공하는 프로토콜입니다. ASGI는 Python 웹 애플리케이션을 구축할 때 비동기 처리를 지원하고, 실시간 기능을 구현할 수 있도록 하는 중간 계층 역할을 합니다.

기존의 WSGI(웹 서버 게이트웨이 인터페이스)는 동기적인 요청과 응답을 다루는 데에 효과적이었습니다. 하지만 현대의 웹 애플리케이션에서는 동시성(concurrency)이나 비동기(asynchronous) 처리가 중요한 역할을 하게 되면서 WSGI의 한계가 드러나게 되었습니다.

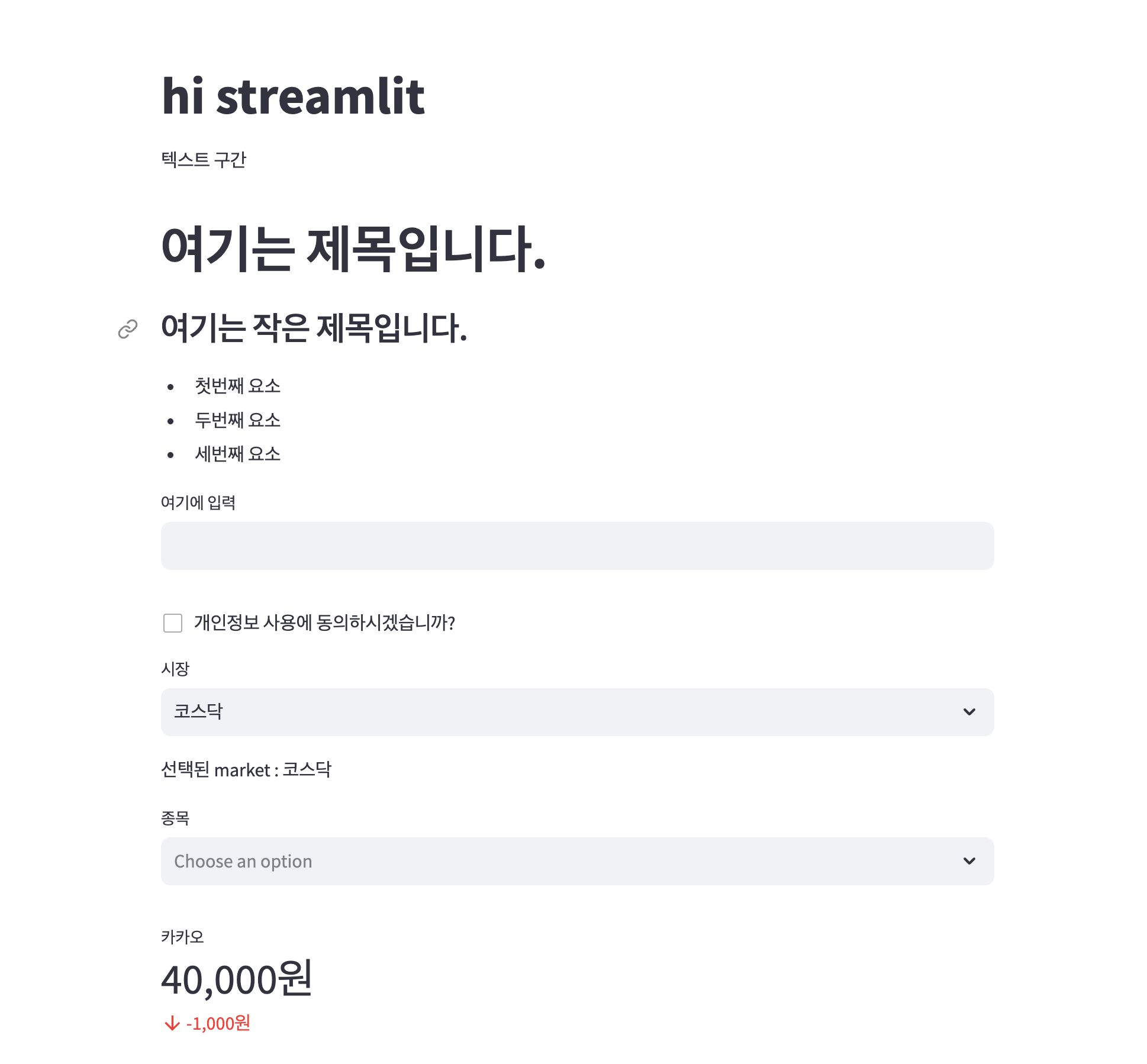

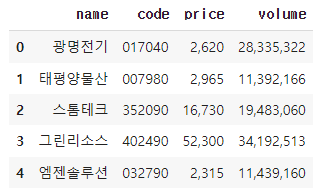

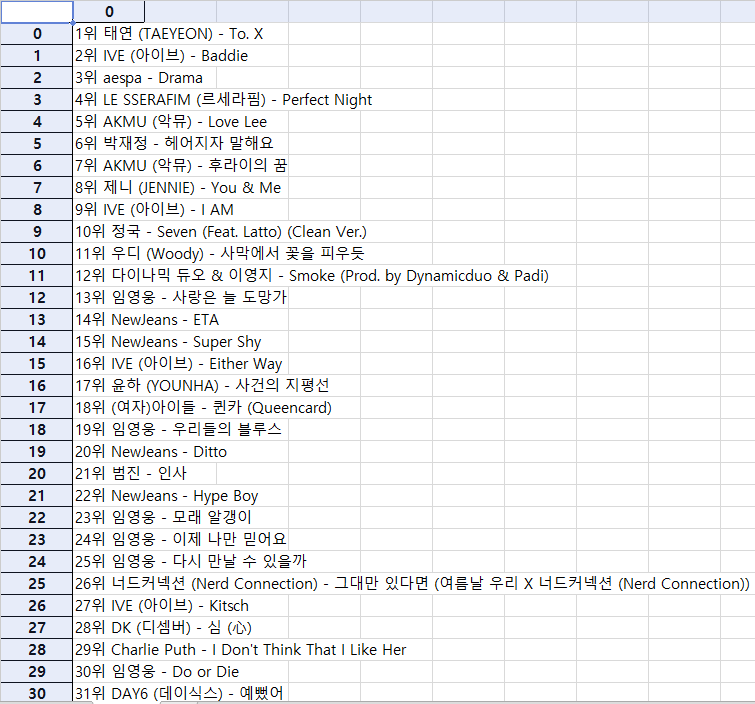

4. 기본 예제

main.py

from fastapi import FastAPI

users = {

0: {"userid": "apple", "name": "푸바오"},

1: {"userid": "banana", "name": "아이바오"},

2: {"userid": "orange", "name": "러바오"}

}

app = FastAPI()

# http://127.0.0.1:8000/users/0

# uvicorn main:app --reload

@app.get("/users/{id}")

def find_user(id: int):

user = users[id]

return user

# http://127.0.0.1:8000/users/0/userid

# http://127.0.0.1:8000/docs

@app.get("/users/{id}/{key}")

def find_user_by_key(id: int, key: str):

user = users[id][key]

return user

5. 실행

작성한 FastAPI 애플리케이션을 실행합니다. 다음 명령을 사용하여 uvicorn을 통해 실행할 수 있습니다.

uvicorn main:app --reload

FastAPI는 자동으로 생성된 Swagger UI를 통해 API 문서를 제공합니다. 기본적으로 http://127.0.0.1:8000/docs 또는 http://127.0.0.1:8000/redoc에서 확인할 수 있습니다. Swagger UI를 통해 API의 엔드포인트, 매개변수, 응답 형식 등을 살펴볼 수 있습니다.

6. REST와 RESTful API

REST: "Representational State Transfer"의 약자로, 웹 상에서 자원을 표현하고 상태를 전송하기 위한 아키텍처적인 스타일입니다. REST는 네트워크 아키텍처의 한 형식으로, 리소스(자원)를 정의하고 이를 고유하게 식별하는 데 중점을 두며, HTTP 프로토콜을 기반으로 하고 있습니다. REST는 간결하고 확장 가능한 디자인을 지향하여 웹 서비스를 위한 표준 아키텍처로 널리 사용되고 있습니다.

RESTful API(REST API): REST 아키텍처를 따르는 웹 서비스의 인터페이스를 말합니다. 이 API는 클라이언트와 서버 간의 통신을 위한 규칙을 제공하며, 자원의 생성, 조회, 수정, 삭제(CRUD)와 같은 기본적인 데이터 조작을 위한 메서드를 제공합니다. RESTful API는 HTTP를 기반으로 하기 때문에 웹에서 쉽게 사용할 수 있습니다. 클라이언트와 서버 간의 통신은 자원의 표현을 통해 이루어지며 표현은 일반적으로 JSON 또는 XML 형식으로 이루어집니다.

예를 들어, 다음은 간단한 RESTful API의 예시입니다:

자원(리소스): /users

HTTP 메서드: GET (모든 사용자 조회), POST (새로운 사용자 생성), PUT 또는 PATCH (사용자 정보 업데이트), DELETE (사용자 삭제)

7. JSON

JSON은 "JavaScript Object Notation"의 약어로, 데이터를 표현하고 교환하기 위한 경량의 데이터 형식입니다. 주로 서버와 클라이언트 간에 데이터를 주고 받을 때 사용되며, 텍스트 형태로 이루어져 있습니다. JSON은 간결하면서도 읽기 쉽고 파싱하기 쉬운 구조를 가지고 있어 많은 프로그래밍 언어에서 지원하고 있습니다.

{

"키1": "값1",

"키2": "값2",

"키3": {

"키4": "값4",

"키5": "값5"

},

"배열키": [

"배열값1",

"배열값2",

"배열값3"

]

}

8. HTTP Method

FastAPI에서는 각 메서드에 대응하는 데코레이터를 제공하여 해당 엔드포인트에 대한 핸들러 함수를 등록할 수 있습니다. 이러한 데코레이터를 사용하여 각각의 HTTP 메서드에 대한 동작을 정의할 수 있습니다.

from fastapi import FastAPI

from pydantic import BaseModel

from typing import Optional

users = {

0: {"userid": "apple", "name": "푸바오"},

1: {"userid": "banana", "name": "아이바오"},

2: {"userid": "orange", "name": "러바오"}

}

app = FastAPI()

# http://127.0.0.1:8000/user/?

@app.get("/users/{id}")

def find_user(id: int):

item = users[id]

return item

# http://127.0.0.1:8000/users/0/userid

@app.get("/users/{id}/{key}")

def find_user_by_key(id:int, key:str):

user = users[id][key]

return user

# http://127.0.0.1:8000/id-by-name?name=푸바오

@app.get("/id-by-name")

def find_user_by_name(name:str):

for userid, user in users.items():

if user['name'] == name:

return user

return {"error : 데이터를 찾지 못함"}

class User(BaseModel):

userid : str

name : str

@app.post("/{id}")

def create_user(id: int, user: User):

if id in users:

return {"error" : "이미 존재하는 키"}

users[id] = user.__dict__ # user객체를 딕셔너리로 만듬

return {"success" : "ok"}

class UserForUpdate(BaseModel):

userid: Optional[str]

name: Optional[str]

@app.put("/{id}")

def update_user(id:int, user: UserForUpdate):

if id not in users:

return {"error" : "id가 존재하지 않음"}

if user.userid :

users[id]['userid'] = user.userid

if user.name:

users[id]['name'] = user.name

return {"success" : "ok"}

@app.delete("/users/{id}")

def delete_item(id:int):

users.pop(id)

return {"success": "ok"}